实验室4篇论文被第39届AAAI人工智能年度会议接收

字号:【大】 【中】 【小】

AAAI(AAAI Conference on Artificial Intelligence) 由国际先进人工智能协会主办,是人工智能领域的顶级国际学术会议之一。第39届AAAI人工智能年度会议将于2025年2月在美国宾夕法尼亚州费城召开。

01. 基于自适应预训练视觉编码器的高效强化学习算法

Efficient Reinforcement Learning through Adaptively Pretrained Visual Encoder

作者:张予涵(共一),马国庆(共一),郝光福,郭良轩,陈阳,余山

虽然强化学习(RL)智能体能够成功学习复杂的任务,但泛化这些技能到新环境仍然具有挑战性。这背后的原因之一是所使用的视觉编码器是任务相关的,使得在不同环境下的特征提取受限。为了解决这一问题,我们提出了APE:一种通过自适应预训练视觉编码器来实现高效强化学习的框架。实验结果表明,配备APE的主流RL算法在多个环境中均实现了一定的性能提升,并显著提高了原有算法的学习效率。在仅使用视觉信息的情况下,其性能接近基于状态输入的策略。这展示了编码器自适应预训练在提升视觉强化学习泛化能力和效率方面的潜力。

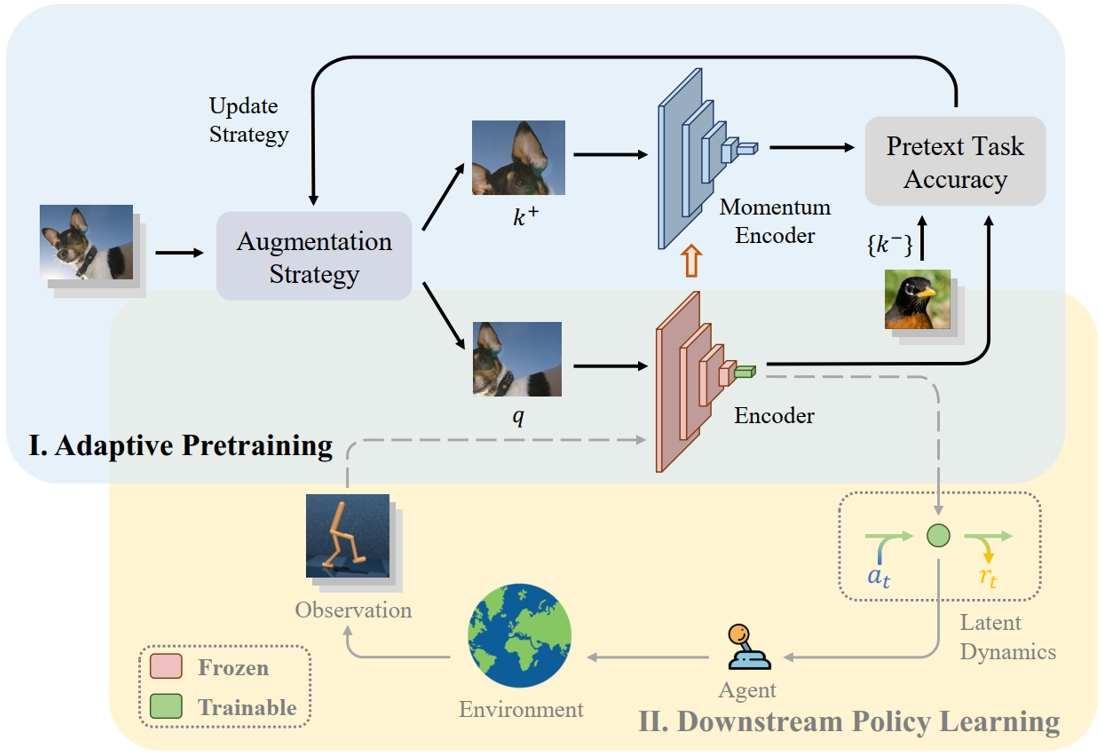

用于基于模型的强化学习的APE框架。训练阶段分为两个部分,分别是自适应预训练阶段(蓝色区域)和下游策略学习阶段(黄色区域)。在第一个阶段中,使用自适应数据增强策略对各种现实场景中的图像进行增强,该策略在下一个预训练周期中动态更新每个增强集合的采样概率。在第二阶段,将预训练的视觉编码器作为策略的感知模块应用于通用RL算法框架中。

02. 基于多模态隐变量的跨个体初级视觉皮层建模和分析

Multi-Modal Latent Variables for Cross-Individual Primary Visual Cortex Modeling and Analysis

作者:朱宇,雷博,宋纯锋,欧阳万里,余山,黄铁军

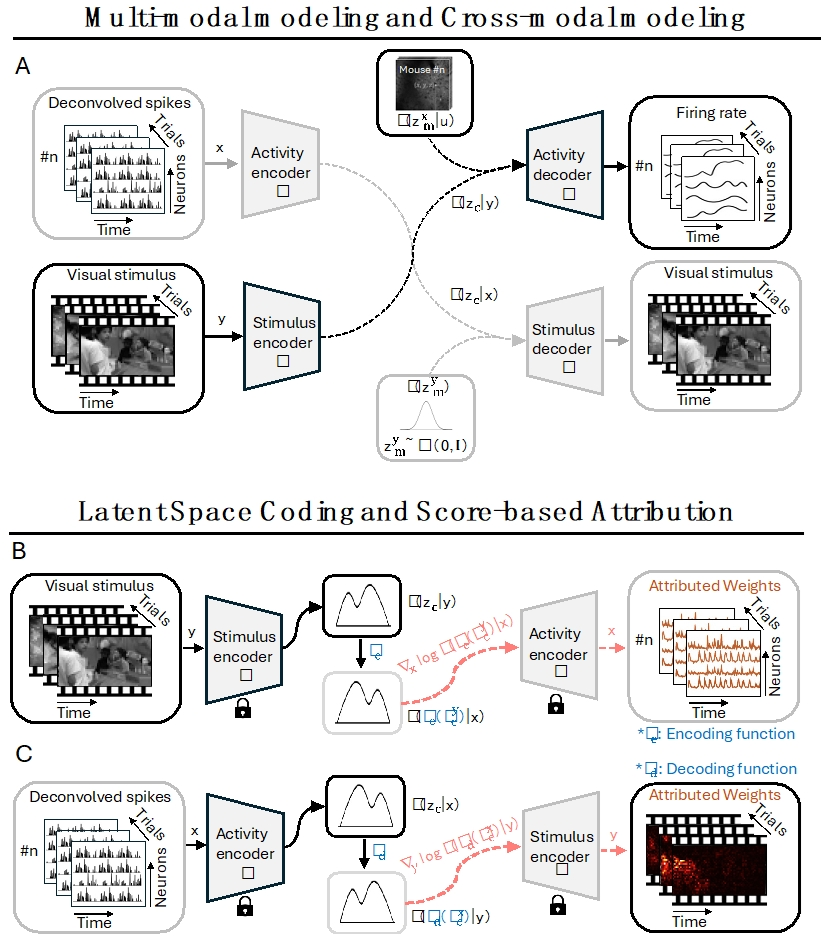

在系统神经科学领域中,理解初级视觉皮层(V1)的功能机制仍然是一个基本挑战。当前的计算模型面临两个关键限制:一是部分神经记录与复杂视觉刺激之间跨模态整合的挑战,二是个体间神经特征的固有差异,包括神经元群体和发放模式的差异。为了应对这些挑战,我们提出了一个多模态可识别变分自编码器(miVAE),它采用两级解耦策略将神经活动和视觉刺激映射到统一的潜在空间。该框架通过精细的潜在空间建模,实现了跨模态相关性的稳健识别。我们还配合使用了一种新颖的基于得分的归因分析方法,用于追踪潜在变量回溯到源数据空间的来源。在大规模小鼠V1数据集上的评估表明,我们的方法在跨个体潜在表征和对齐方面达到了最先进的性能,且无需针对特定个体进行微调,并且随着数据规模的增加表现出更好的性能。值得注意的是,我们的归因算法成功识别出具有独特时间模式和刺激辨别特性的不同神经元亚群,同时揭示了对边缘特征和亮度变化具有特定敏感性的刺激区域。这个可扩展的框架不仅为推进V1研究提供了有前景的应用,也为更广泛的神经科学研究提供了新的可能。

03. EventZoom:用于增强神经形态视觉任务的渐进式事件数据增强方法

EventZoom: A Progressive Approach to Event-Based Data Augmentation for Enhanced Neuromorphic Vision

作者:董一廷,何翔,申国斌,赵东城,李杨,曾毅

动态视觉传感器(DVS)以高时间分辨率和低功耗捕获事件数据,相比传统的视频获取方法,在动态和实时场景中提供了更高效的解决方案。事件数据增强作为克服事件数据集规模和多样性限制的方法,对于提升模型的性能至关重要。对比实验表明,空间完整性和时间连续性这两个因素显著影响事件数据增强的能力,它们是保持事件数据特有稀疏性和高动态范围特征的保证。然而,现有的增强方法通常忽视了这两个因素。我们开发了一种全新的事件数据增强策略—EventZoom,该策略采用时序渐进策略,通过渐进式的缩放和平移将变换样本嵌入原始样本中。缩放过程避免裁剪带来的空间信息丢失,而渐进策略则防止时序信息的中断或突变。我们在多种监督学习框架中验证了EventZoom。实验结果表明,EventZoom在性能上始终优于现有的事件数据增强方法,达到最先进的水平。我们首次同时采用半监督和无监督学习来验证事件增强算法的可行性,展示了EventZoom在处理具有高动态性和多变性环境的实际场景中的适用性和有效性。

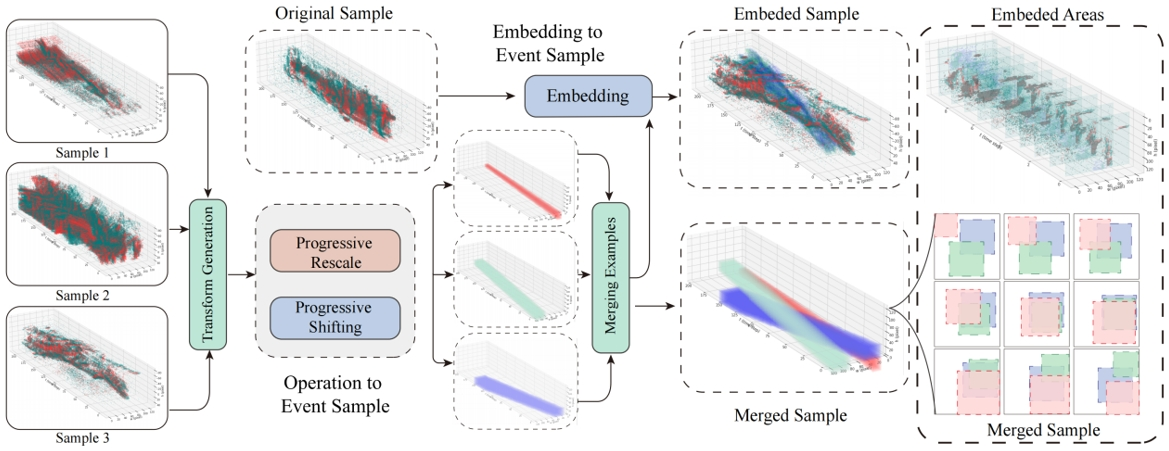

EventZoom的数据增强过程。事件样本1-3经过了沿时间维度的渐进式缩放和平移,缩放后的样本被嵌入到原始样本中。

04. StressPrompt: 压力是否对大型语言模型和人类表现产生类似的影响?

StressPrompt: Does Stress Impact Large Language Models and Human Performance Similarly?

作者:申国斌,赵东城,包傲日格乐,何翔,董一廷,曾毅

人类常常会面临压力,而压力会显著影响其表现。本研究探讨了大型语言模型(LLMs)是否会展现与人类类似的压力反应,以及其在不同压力诱导情境下的表现波动情况。为此,我们设计了一套名为StressPrompt的全新提示集,旨在诱导不同程度的压力。这些提示基于公认的心理学理论框架,并经过人类参与者的评分校准后精心调整。随后,我们将这些提示应用于多个LLMs,评估其在包括指令执行、复杂推理和情感智能等任务中的表现。研究结果显示,LLMs与人类类似,在中等压力下表现最佳,这与Yerkes-Dodson法则相一致。而在低压力或高压力条件下,其表现均有所下降。此外,分析表明,这些StressPrompt会显著改变LLMs的内部状态,导致其神经表征发生变化,这种变化与人类面对压力时的反应相似。本研究为LLMs的操作稳健性和灵活性提供了重要见解,强调了在客户服务、医疗保健和紧急响应等高压力的真实世界场景中,设计能够保持高性能的AI系统的重要性。同时,本研究为更广泛的AI研究领域提供了新视角,深入探讨了LLMs如何应对不同情境及其与人类认知的相似性。

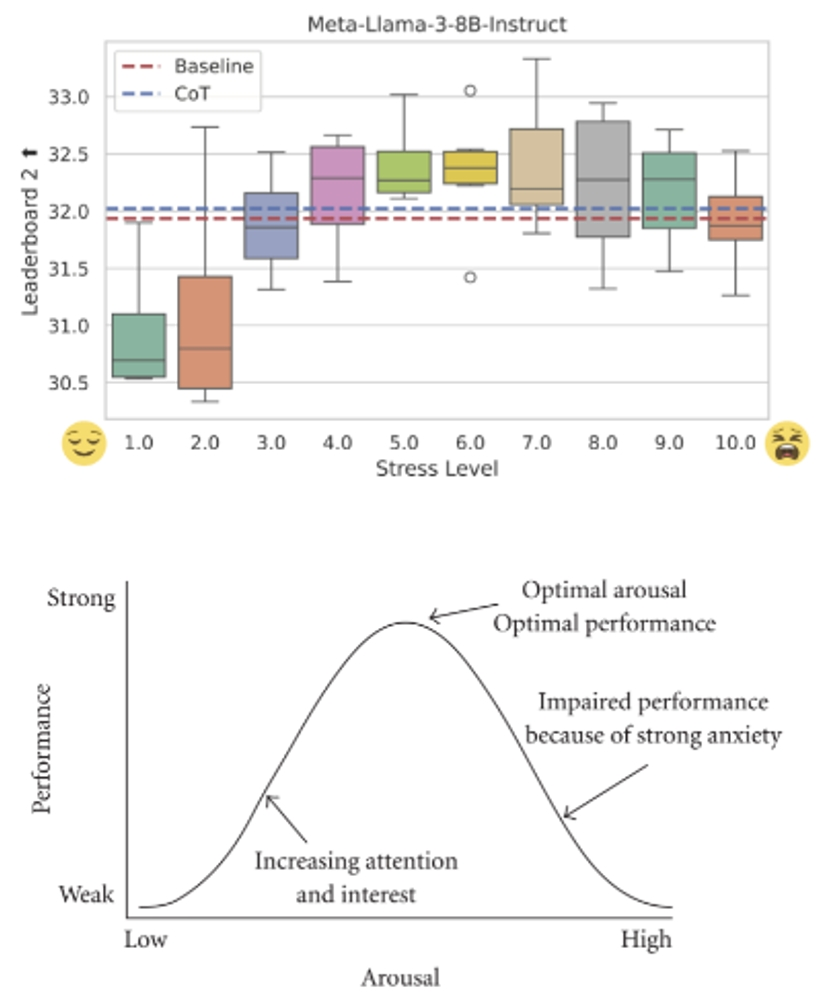

对比 LLM 和人类在不同压力水平下的表现: (a) Llama-3-8B-Instruct在不同压力水平下的 Leaderboard 2 基准测试表现。(b) Yerkes-Dodson 法则示意图:人类表现随压力水平变化,在中等压力下达到峰值,而在低压力或高压力下下降。(https://en.wikipedia.org/wiki/Yerkes–Dodson_law)

版权所有 © 脑图谱与类脑智能实验室

备案序号:京ICP备14019135号-3 京公网安备110108003079号

地址:北京市海淀区中关村东路95号 邮编:100190 mail:brain-ai@ia.ac.cn