实验室3篇论文被第38届AAAI人工智能会议接收

字号:【大】 【中】 【小】

日前,中国计算机学会(CCF)推荐的A类国际学术会议 AAAI公布论文接收结果。AAAI(AAAI Conference on Artificial Intelligence) 由国际先进人工智能协会主办,是人工智能领域的顶级国际学术会议之一。第38届AAAI人工智能年度会议将于2024年2月在加拿大温哥华举行。本文将介绍中国科学院自动化研究所脑图谱与类脑智能实验室在AAAI 2024中录用的3篇论文(排序不分先后)。

1. 神经群体编码启发的连续旋转群等变网络

Continuous Rotation Group Equivariant Network Inspired by Neural Population Coding

论文作者:陈智强,陈阳,邹晓龙,余山

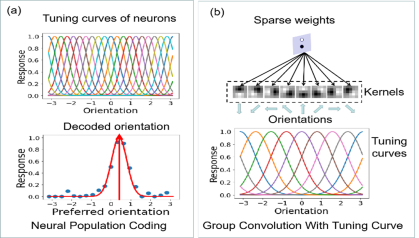

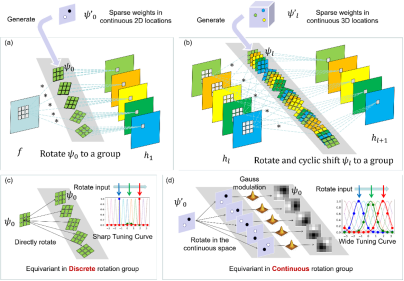

研究介绍:群体编码在生物神经元中是一个普遍的机制,比如海马中的‘place cell’、初级视觉皮层的方向、颜色、朝向等神经元都是通过群体编码的方式来编码信息的。钟型调谐曲线(bell-shaped tuning curve)对于神经群体编码通过离散的最优刺激来编码连续信息是至关重要的。受此启发,我们通过高斯调制将钟型的调谐曲线嵌入到离散的群等变卷积中,从而实现使用离散群卷积达到连续群等变的目的。受益于高斯调制,卷积核在几何维度上(如位置维度、方向维度)也具有平滑的梯度,这使得可以使用稀疏的带有可学习几何参数的权重来生成群等变卷积核,从而使得网络既具有竞争性的性能又具有极高的参数效率。实验结果表明:1)在MNIST-rot上相比于之前的方法,我们的方法能够使用更少的参数(少于25%)达到极具竞争力的性能;2)尤其是在小样本学习下,我们的方法能够得到更加显著的性能提升(24%);3)同时在更多的数据集(如MNIST、CIFAR和ImageNet)和不同的网络架构上(平直网络架构和ResNet架构)都具有不错的旋转泛化能力。

2. 从静态域到事件域的脉冲神经网络知识迁移策略

An Efficient Knowledge Transfer Strategy for Spiking Neural Networks from Static to Event Domain

论文作者:何翔,赵东城,李杨,申国斌,孔庆群,曾毅

研究介绍:

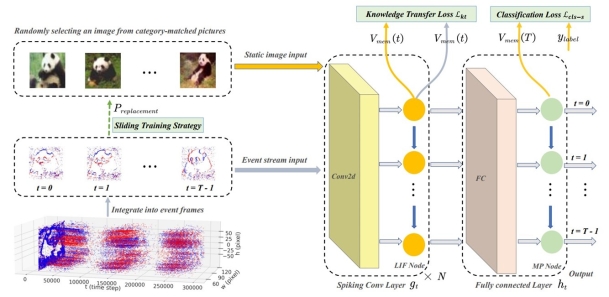

脉冲神经网络 (SNN) 因为其事件驱动的优势而著称,时间上的特征使得SNN适合处理事件数据。然而事件数据往往规模较小,从而限制了其进一步发展。

相比而言,静态的RGB数据集规模较大且更易获取。尽管静态的图片能为事件数据提供有价值的空间信息,然而由于事件数据与静态图片是两种不同的模态,它们存在着固有的域差异.

为了减小域差异,从而优化SNN在事件数据上的表现,我们主要从两个方面来进行解决:第一是特征分布,第二是训练策略。对于特征分布,我们设计了知识转移损失函数,其包括域对齐损失和时空正则化。域对齐损失通过减少静态图像和事件数据之间的边缘分布距离,来学习和获取域不变空间特征。时空正则化为域对齐损失提供动态调整的系数,以更好地学习数据中的时间特征。在训练策略方面,我们提出了滑动训练策略,即在训练过程中用事件数据概率性地逐步替换静态图像输入,从而平滑地减少知识转移损失的作用,使训练过程更加稳定。在三个数据集上的实验结果充分表明了所提方法的有效性。

相关代码开源在:

3. 用于训练高性能和高效尖峰神经网络的门控注意力编码

Gated Attention Coding for Training High-performance and Efficient Spiking Neural Networks

论文作者:邱雪睿,朱芮捷,侴雨宏,王昭睿,邓良剑,李国齐

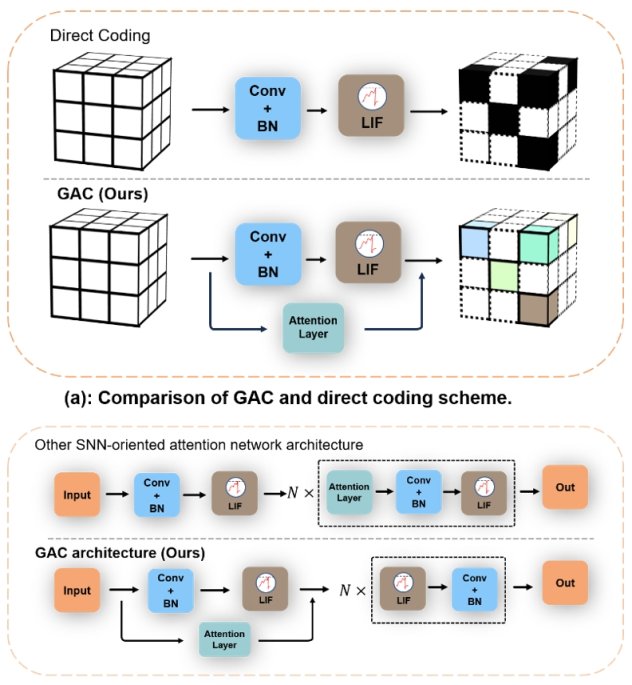

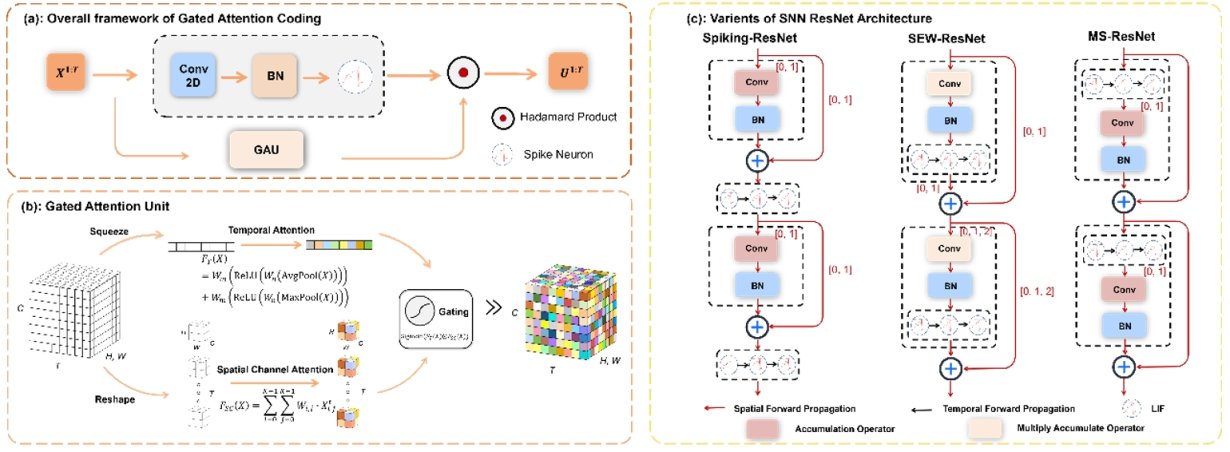

研究介绍:在脉冲神经网络中,编码至关重要,它将外部输入刺激转换为空间时间特征序列。然而,大多数现有的深层脉冲神经网络依赖简单的直接编码方案,生成的脉冲表示较弱,缺乏人类视觉中固有的时间动态特性。因此,我们提出了门控注意力编码(GAC),这是一个即插即用的模块,利用多维门控注意力单元高效地将输入编码为强大的表示,然后馈送到脉冲神经网络架构中。GAC充当预处理层,不会破坏脉冲神经网络的基于脉冲的本质,使其易于在仅需最小修改的情况下实现高效的神经形态硬件。通过观察者模型理论分析,我们证明了GAC的注意力机制改进了时间动态和编码效率。在CIFAR10/100和ImageNet数据集上的实验表明,GAC实现了最先进的准确率与卓越的效率。值得注意的是,我们仅用6个时间步长就在CIFAR100上将top-1准确率提高了3.10%,在ImageNet上的提高了1.07%,同时将能耗降低到之前工作的66.9%。我们最先探索了深度脉冲神经网络中基于注意力的动态编码方案,在大规模数据集上显示了卓越的效果和效率。

图1.门控注意力机制编码(GAC)与其他方法的比较

图2.门控注意力机制编码(GAC)的具体细节实现.

代码链接:https://github.com/bollossom/GAC

版权所有 © 脑图谱与类脑智能实验室

备案序号:京ICP备14019135号-3 京公网安备110108003079号

地址:北京市海淀区中关村东路95号 邮编:100190 mail:brain-ai@ia.ac.cn